Adicionar viés ao modelo estatístico é uma coisa estranha de se escutar. Na verdade, não parece fazer muito sentido. Um modelo ter mais viés que outro e ainda ser melhor soa esquisito. Mas acredite, isso é possível. E é com base nisso que entra um tema importantíssimo em machine learning chamado REGULARIZAÇÃO.

Quando lidamos com o famoso métodos de mínimos quadrados, estamos tentando minimizar o viés do modelo. O grande problema disso é que podemos nos deparar com o famoso overfitting.

Para quem não se lembra, de forma prática, overfitting ocorre quando você cria um modelo incapaz de extrapolar o aprendizado, um modelo que aprende até os erros da base treinada. A forma mais fácil de ver isso é quando você tem um modelo que acerta muito no treino, mas erra muito no teste. Se ainda te parece confuso, veja os posts Overfitting, Explicando overfitting com uma anedota e Overfitting e Cross Validation.

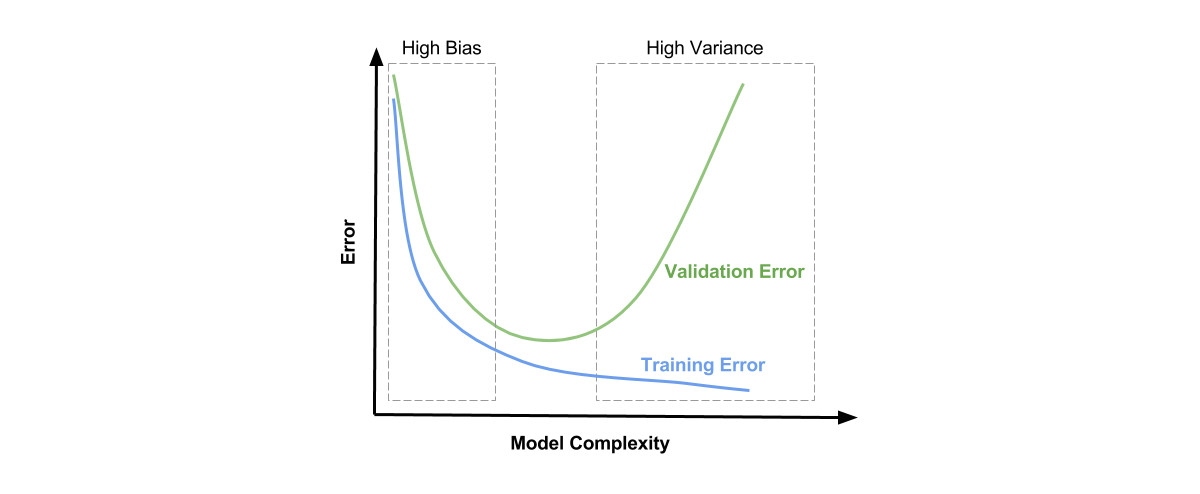

Um meio de resolver este problema de aprendizado é adicionando um pouco de viés ao modelo. Inclusive, aqui já entramos brevemente em outro assunto famoso em machine learning: o tradeoff viés x variância. Quando criamos um modelo, queremos que ele tenha boa acurácia, que acerte as previsões, ou seja, que ele tenha baixo viés. Porém, queremos que ele seja capaz de aprender quando chegarem novos dados, ou seja, queremos que ele tenha baixa variância. Quando aumentamos muito o viés, perdemos em variância e vice-versa. Encontrar o ponto ótimo é uma das missões dos cientistas de dados ou engenheiros de machine learning. Métodos de mínimos quadrados resolvem o primeiro problema, mas tendem a falhar no segundo. Ou seja, possuem alta variância e não conseguem extrapolar o aprendizado. Para resolver isso, adicionamos viés.

Tudo isso nos leva a regularização, um método que busca penalizar a complexidade dos modelos, reduzindo sua variância. Os meios de se fazer isso:

- L1: Limita os valores dos coeficientes, criando “sparse models”, como na Regressão Lasso.

- L2: Não reduz número de coeficientes, mas adiciona uma penalidade igual ao quadrado da magnitude dos coeficientes, que serão reduzidos pelo mesmo fator, como na Regressão Ridge e SVM.

- Elastic Net: combina L1 e L2, adicionando um hiperparâmetro.

Agora você pode melhorar modelos que estão overfittados, com muito viés, multicolinearidade e/ou poucos dados para a quantidade de parâmetros.

Gostou do conteúdo? Se inscreva para receber as novidades! Deixe seu e-mail em INSCREVA-SE na barra à direita, logo abaixo de pesquisar. E, por favor, não deixe de comentar, dar seu feedback e compartilhar com seus amigos. De verdade, isso faz toda a diferença. Você também pode acompanhar mais do meu trabalho seguindo a conta de Twitter @EstatSite ou por alguma das redes que você encontra em Sobre o Estatsite / Contato, como meu canal de Youtube Canal do Yukio.

Bons estudos!