A diferença para a regressão linear simples é que a palavra múltipla aqui faz referência às múltiplas variáveis explicativas, ou seja, teremos duas ou mais variáveis independentes explicando nossa variável dependente, também chamada de variável resposta.

Colocando de uma forma bem simples, lembra que tínhamos uma equação da reta? Aquela equaçãozinha y = a*x + b? Então, agora a diferença é que temos mais x, que serão acompanhados de mais a:

![]()

Ou seja, temos um monte de x para explicar nosso y.

E aí você leu e releu, mas…

CALMA! Eu prometi estatística e econometria fácil, e a gente vai ter! Vamos tentar enxergar através de um exemplo:

Recapitulando, uma regressão linear simples é a equação de uma reta, onde o valor de y é o valor de algo que queremos explicar, e o valor de x é o que vai nos ajudar a explicar y. Até aí tranquilo, você vai observar certos valores e tenta obter uma equação que vai mostrar, dado esses valores, qual é o valor do y que você busca.

Por exemplo, digamos que a nota do aluno seja afetada pela distância da casa dele até a escola e o valor da sua mesada. Se o aluno recebe uma baita mesada, ele é mais feliz, ele come melhor, ele está mais disposto a estudar, então sua nota fica alta a medida que a mesada aumenta. Se o aluno mora perto do colégio, ele tira uma nota maior do que se morasse longe, ou seja, quanto maior a distância de um aluno ao colégio, menor a nota. Uma regressão linear múltipla nos dá uma equação que, observado um certo valor de mesada e uma distância, vamos estimar a nota de um aluno.

Vamos supor que você rodou a regressão em um software qualquer e chegou em:

nota do testão = 2 * mesada – 3 * distância,

onde a mesada é em unidade de reais e a distância é em unidade de km.

Ou seja, se um aluno ganha 15 reais de mesada, e mora a 2km de distância, a nota dele nessa equação será 2 * 15 – 3 * 2 = 24.

É isso que queremos obter quando falamos de uma regressão linear múltipla, queremos essa equação com múltiplas variáveis independentes (no caso a mesada e a distância) que explica uma variável dependente (no caso a nota do testão).

Agora apenas para os guerreiros. Vamos detalhando um pouquinho mais, mas sem exagerar porque esse é apenas o primeiro post sobre regressão linear múltipla.

As premissas para uma regressão linear múltipla são:

- A variável dependente e as variáveis independentes possuem uma relação linear, ou seja, assim como para regressão linear simples, temos uma equação linear que explica nossa variável dependente. Ou como alguns livros dizem, é linear nos parâmetros (parâmetros são as variáveis que você vai usar para explicar a variável resposta).

Você vai ter algo assim:

![]()

Onde cada a é um coeficiente e x a variável explicativa.

Veja bem, a linearidade está nos parâmetros. Isto é uma regressão linear nos parâmetros:

![]()

Isto não é uma regressão linear nos parâmetros:

![]()

- X são fixos ou covariância dos x e erros é zero. Se você não está trabalhando com regressores pré-determinados ( fixos), então a covariância deles com os erros deve ser zero. Por que? Porque não queremos dependência entre as variáveis explicativas e os erros.

- A esperança do erro é zero. Análogo ao que ocorre com a regressão linear simples. Lembra daquela intuição? Erramos um pouquinho para cima, um pouquinho para baixo e fechou!

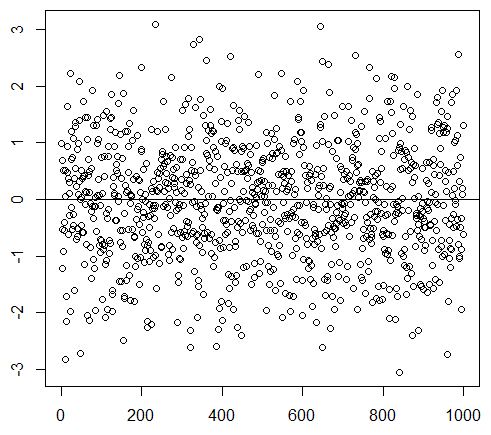

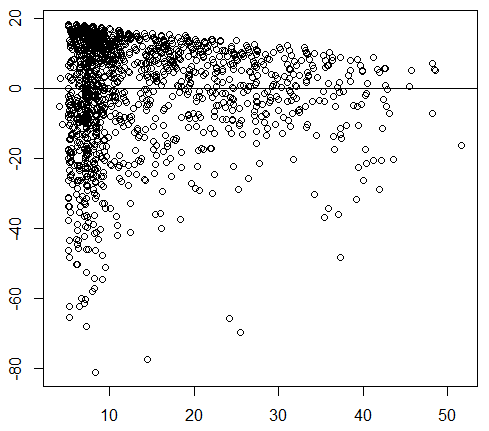

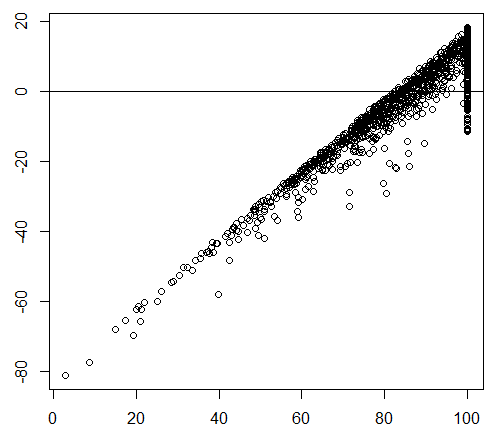

- A variância do erro é constante. Dá para perceber que os erros são importantes aqui, certo? O que é até fácil de intuir, se eles possuem um comportamento como alguma tendência, por exemplo de uma reta, ou eles explodem, então é provável que tenhamos variáveis que expliquem a variável resposta e não foram incluídas. Veja as fotos abaixo.

- Não há autocorrelação entre os erros. More on that later!

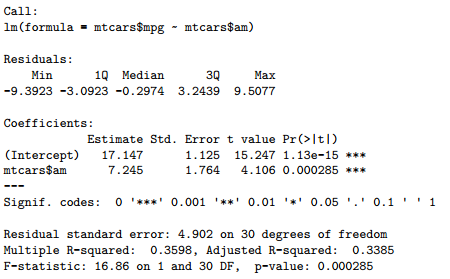

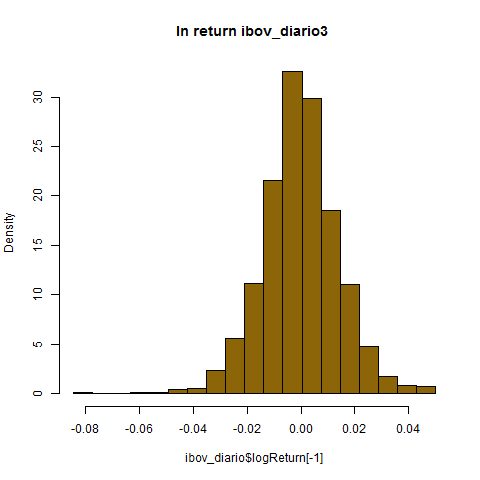

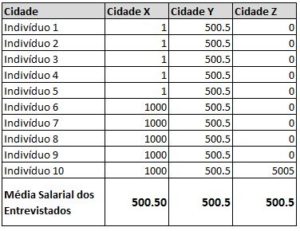

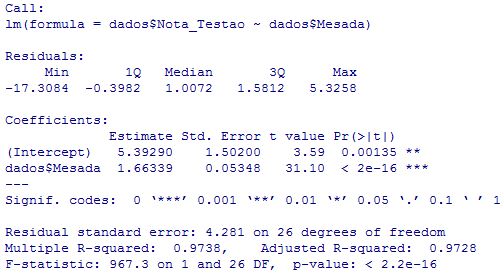

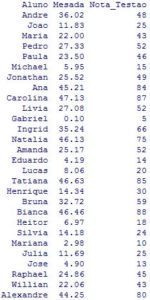

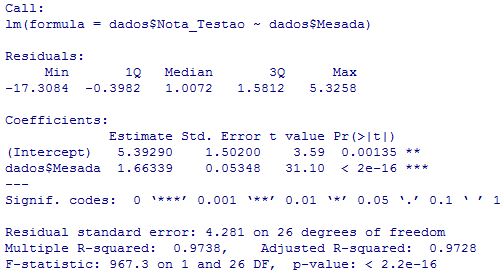

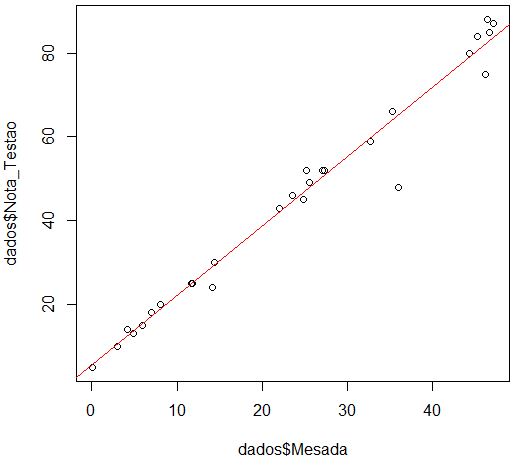

E como vamos saber exatamente quanto que um aumento na mesada impacta a nota dos alunos? Vamos rodar uma regressão no R da variável Mesada (variável independente) em Nota_Testão (nossa variável dependente) e verificar os resultados:

E como vamos saber exatamente quanto que um aumento na mesada impacta a nota dos alunos? Vamos rodar uma regressão no R da variável Mesada (variável independente) em Nota_Testão (nossa variável dependente) e verificar os resultados: O que nos importa do resultado acima?

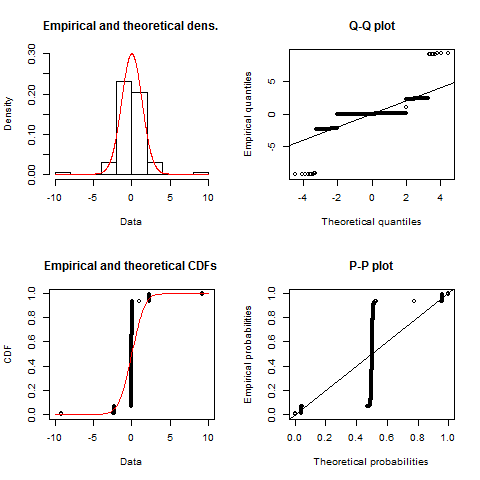

O que nos importa do resultado acima? Agora, para os iniciantes em R, aí vai 5 linhas de código que gera esses gráficos e essa regressão (para executá-los não colocar os números na frente!):

Agora, para os iniciantes em R, aí vai 5 linhas de código que gera esses gráficos e essa regressão (para executá-los não colocar os números na frente!):