Já adiantando, esse post é para discutir alguns métodos econométricos. A discussão sobre o tema dos artigos utilizados não é relevante no contexto do post. Sugiro ainda a leitura do artigo Using Terror Alert Levels to Estimate the Effect of Police on Crime e do livro Freakonomics: O Lado Oculto e Inesperado de Tudo que nos Afeta (além dos que serão mencionados).

A polícia é bastante defendida e atacada pelas pessoas. De um lado os que acreditam na sua efetividade em combater o crime, do outro os mais céticos que acreditam que a polícia não é eficiente e é, muitas vezes, até pior para uma comunidade. Eu não estou aqui para discutir o que é certo e o que é errado, e sim mostrar como a estatística e a econometria são úteis na decisão de políticas que melhorem o bem estar geral e a não sermos enganados por qualquer correlação apresentada por aí.

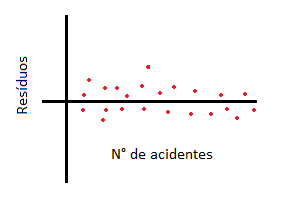

Encontrar essa causalidade entre polícia e criminalidade não é fácil. Samuel Cameron, 1988, analisou 22 papers, desses, 18 indicavam uma relação positiva entre aumento policial e aumento de criminalidade ou então nenhuma relação. Nenhum conseguiu concluir que o aumento no número de policiais diminuía a criminalidade. Esses estudos, porém, não trataram o problema de endogeneidade. Endogeneidade ocorre quando seu erro e uma variável regressora estão correlacionados. Quando ela ocorre você não tem ideia de quem causa o que. E isso ocorre no nosso caso. Pense em um prefeito cuja cidade tem uma taxa de criminalidade alta. É bem provável que ele contrate mais policiais. Ou seja, muitos policiais em uma área de alta criminalidade, ou o contrário. Isso acaba enviesando nosso modelo.

E o que os estudos mais recentes nos dizem?

No artigo Panic on the Streets of London: Police, Crime, and the July 2005 Terror Attacks, Mirko Draca, Stephen Machin, and Robert Witt, utilizando diversas técnicas econométricas buscam explicar a causalidade entre policiamento e criminalidade.

Utilizando principalmente Difference in Differences eVariáveis Instrumentais, o paper analisa esse efeito utilizando o aumento do policiamento que ocorreu na Inglaterra após um ataque terrorista. É um material bem completo e uma análise cuidadosa, que considera efeitos de tendência (e se o bairro já estiver passando por uma redução de crimes?), teste de Placebo (análogo ao placebo quando falamos de remédios, mas para nossos grupos tratados) , dentre outras coisas.

Variáveis Instrumentais

Essa variáveis são utilizadas no estudo para lidar com o problema de endogeneidade que fazem com que nossos parâmetros de OLS sejam inconsistentes.

Para encontrar uma variável instrumental, precisamos de uma variável que impacta a variável resposta y através da variável explicativa x. Um exemplo famoso, citado no livro Mostly Harmless Econometrics, Angrist e Pischke, é de um estudo que buscava encontrar a relação entre anos de escolaridade e salário, que possuía a variável habilidade dentro do erro do modelo. A variável instrumental utilizada foi trimestre de nascimento, que impactava o salário, porém, através da variável escolaridade.

Para o estudo citado no início desse post, a variável encontrada foi o ataque terrorista. Note que essa variável de nada adiantaria para explicar a redução de criminalidade, porém, ao afetar o efetivo policial, ela acaba impactando a criminalidade. Essa é a intuição que eu acredito ser necessária para você entender o que é uma variável instrumental.

O resultado do estudo?

We find strong evidence that more police lead to reductions in what we refer to as susceptible crimes (i.e., those that are more likely to be prevented by police visibility, including street crimes like robberies and thefts)

Ou seja, eles conseguiram evidenciar, que o aumento no policiamento causa redução em crimes que eles chamam de “crimes suscetíveis”, que são os crimes que seriam mais visíveis aos policiais, como roubos, furtos e violência. Isso tudo mesmo com aquela correlação que observamos entre polícia e criminalidade.

Apenas para concluir, o modelo apresentado pelos autores demonstra que outros crimes, como os sexuais, não apresentaram diferenças significativas.

Leia também: Do Police Reduce Crime? Estimates Using the Allocation of Police Forces After a Terrorist Attack

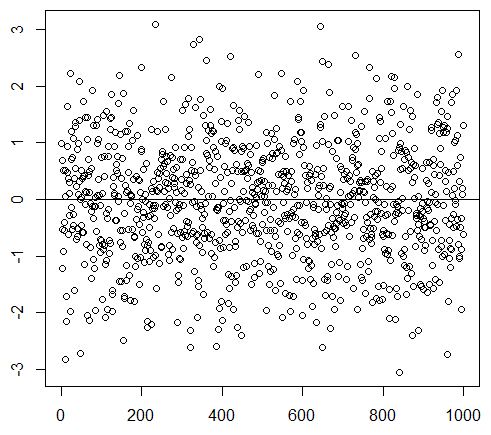

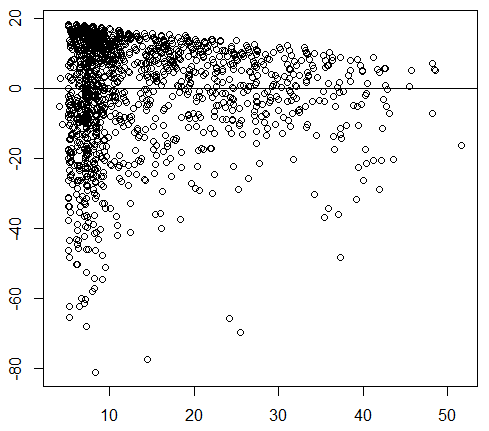

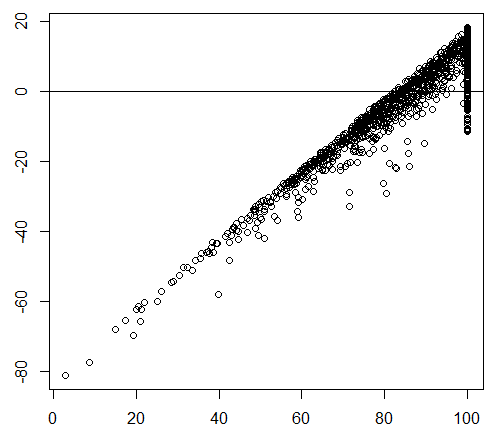

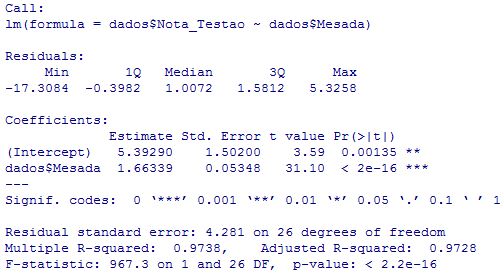

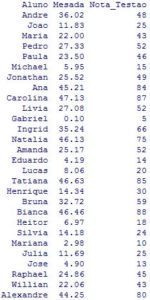

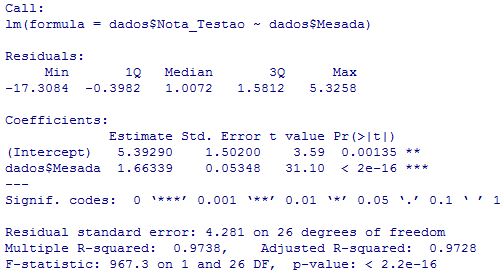

E como vamos saber exatamente quanto que um aumento na mesada impacta a nota dos alunos? Vamos rodar uma regressão no R da variável Mesada (variável independente) em Nota_Testão (nossa variável dependente) e verificar os resultados:

E como vamos saber exatamente quanto que um aumento na mesada impacta a nota dos alunos? Vamos rodar uma regressão no R da variável Mesada (variável independente) em Nota_Testão (nossa variável dependente) e verificar os resultados: O que nos importa do resultado acima?

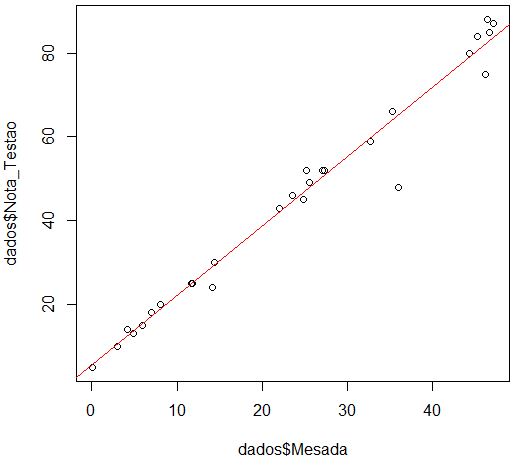

O que nos importa do resultado acima? Agora, para os iniciantes em R, aí vai 5 linhas de código que gera esses gráficos e essa regressão (para executá-los não colocar os números na frente!):

Agora, para os iniciantes em R, aí vai 5 linhas de código que gera esses gráficos e essa regressão (para executá-los não colocar os números na frente!):