Reforçando um pouco os posts Análise dos Resíduos de uma Regressão Linear, veja abaixo como plotar os resíduos de uma regressão para verificar sua normalidade:

Etiqueta: regressao linear

Viés de Variável Omitida: Um exemplo prático

Já mencionei o viés de variável omitida no post Quanto mais polícia, mais crimes? e Paradoxo de Simpson, vamos ver mais um exemplo prático.

Vamos supor que você queira analisar o impacto do número de professores em uma escola com as notas dos alunos. Ou seja, você gostaria de estimar os beta 1 da seguinte equação:

média das notas = β0 + β1*n° de professores + u

É de se esperar que β1 seja maior que 0, pois a expectativa é que um número maior de professores seja benéfico para os alunos por diversos motivos.

Entretanto, pensemos nas variáveis não utilizadas no modelo e que “alocamos” em u. Dentre essas variáveis, temos, por exemplo, o investimento do governo nessas escolas. Afinal, um governo que investe mais, tenderá a contratar mais professores para suprir todas as necessidades da escola. Ou seja, a correlação entre número de professores e investimento do governo é positiva, quanto maior o investimento feito, maior o número de professores. Note que a esperança do u dado o parâmetro n° de professores não é zero. Afinal, como já dissemos, quanto maior o investimento de um governo, maior o número de professores, sendo assim, violamos uma premissa da nossa regressão OLS (ordinal least squares).

Ε (u | n° de professores) ≠ 0

É provável que se calcularmos um coeficiente de valor 10, este valor seja na verdade um valor menor qualquer como 7 ou 5. Isso ocorre porque o parâmetro n° de professores está absorvendo parte do impacto que o investimento do governo causa. O resultado é que nosso coeficiente está com viés, superestimando o impacto da variável.

Este é o problema de se omitir uma variável relevante.

Baseado em: Omitted Variable Bias – Ben Lambert

Reforçando o uso do R-quadrado: por que o autor usou um R-quadrado baixo?

Já falei sobre o R-quadrado no post Regressão Linear Simples – Parte 3. Ainda assim, o r-quadrado é uma medida que pode ter algumas pegadinhas.

Você verá em muitos artigos científicos os autores buscando algum efeito causal, rodando uma regressão e tirando alguma conclusão mesmo que no output da regressão tenha saído um r-quadrado baixo. Pode isso Arnaldo?

De forma rápida, a regra é clara, pode sim!

De forma mais demorada: O r-quadrado é uma medida de dependência linear entre as variáveis, ele vai te ajudar a entender o quanto seu modelo vai explicar a variável dependente. Você deve interpretá-lo como sendo o percentual da variação da variável resposta que é explicada por um modelo linear.

Você foi lá, fez seu experimento, aleatorização certinha, fez os testes legais, a variável independente tem lá um p-valor legalzinho na regressão, de forma intuitiva faz sentido a causalidade dela, mas chegou em um r-quadrado baixo. E aí, deu ruim?

Não, o r-quadrado vai te ajudar a encontrar um bom modelo, um modelo mais robusto em comparação com um modelo mais simples. Mas ele não vai anular o efeito causal que você obteve, por isso você vai sim encontrar regressões em diversos papers renomados explicando alguma causalidade utilizando regressões com baixo r-quadrado.

Para os que falam inglês, leia também: http://blog.minitab.com/blog/adventures-in-statistics/how-high-should-r-squared-be-in-regression-analysis

Você vai ouvir falar por aí: variáveis de controle

Muitas vezes quando você faz uma regressão, você quer saber quanto uma variável impacta a outra, por exemplo quanto um ano a mais de estudos impacta o salário. No entanto, outras variáveis podem afetar o salário, como profissão e até o sexo. Para saber como os anos de estudos impactam o salário, você precisa controlar as demais variáveis e isolar o efeito dos anos de estudos. Sendo assim, as variáveis profissão e sexo devem ser levadas em conta na sua análise, basicamente sendo inseridas na sua regressão. Isso são as variáveis de controle, são variáveis que possivelmente ou com certeza causam efeito na sua variável dependente, no nosso caso o salário, e que devem ser levadas em consideração para que a gente consiga estimar o efeito único de uma variável independente na variável dependente.

Análise dos Resíduos de uma Regressão Linear

Conforme já foi falado neste blog, os resíduos de uma regressão linear são as diferenças entre os pontos observados e a curva que estimamos. Ou seja, você tem lá valores reais que você observou do fenômeno que está analisando e tem a equação da reta que você estimou através de um método qualquer. A diferença entre esses dois valores é o seu resíduo.

Por exemplo, suponha que você queira saber quanto o imposto sobre bebidas alcoólicas e o limite de velocidade de uma via afetam o número de acidentes. Utilizando um método qualquer, você obtém a equação abaixo.

![]()

Onde yi é o número de acidentes na via i, β1 é o imposto sobre bebidas alcoólicas e β2 é o limite de velocidade nesta via.

Se tivermos a avenida XPTO em uma cidade em que o imposto sobre as bebidas é de 20% e o limite de velocidade desta via for 60 km/h, nossa equação nos diz que o número de acidentes da via X deve ser de 100 – 14*0,2 + 0,5* 60 = 127,2.

Observamos que na avenida X, o número de acidentes no mês foi 130. Ou seja, nosso resíduo aqui é de 2,8.

Por enquanto tudo tranquilo, certo?

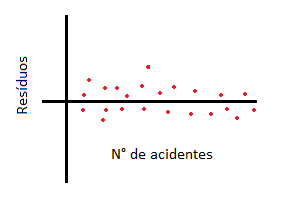

Agora que já entendemos claramente o que é o resíduo, precisamos saber como analisá-lo. Lembre-se que o resíduo deve ter esperança zero. Colocado de maneira prática, o que você precisa, é plotar os valores o seu resíduo com sua variável resposta e obter este gráfico:

Veja que nossos resíduos estão transitando ao redor de zero e que independente do número de acidentes ser alto ou baixo, os resíduos tem esperança zero. É isso que buscamos para ter um modelo mais preciso possível.

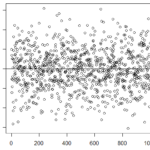

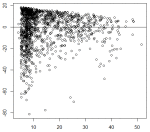

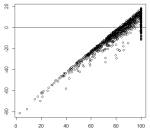

Abaixo mais alguns exemplos de resíduos plotados com as variáveis respostas, note que o gráfico maior a esquerda possui resíduos bem comportados, enquanto os da direita não parecem ter esperança zero e possuem uma tendência, eles variam de acordo com a grandeza da variável resposta:

Leia também: Regressão Linear Simples – Parte 1 e Resíduos de uma Regressão Linear no R

Problemas com R? Que tal começar em Primeiros passos no R Studio!

Erros vs. Resíduos

É comum cometermos o equívoco de chamar erros de resíduos e vice-versa. A definição é próxima mesmo, então não se preocupe se você já cometeu esse erro. Enfim, qual a diferença entre o que chamamos de erros e dos chamados resíduos?

O erro é a diferença entre o valor real, que não observamos, e o valor estimado. Já o resíduo é a diferença entre o valor estimado e o valor observado.

Confuso? Eu sempre achei, então vamos tentar de novo.

Quando realizamos nossa regressão, estamos tentando estimar uma reta que melhor se aproxima do conjunto de pontos que temos observado, mas nós nunca sabemos qual é a reta real que explicaria esse conjunto de pontos. O que nós conseguimos é uma estimativa dessa reta.

Vamos supor que tenhamos uma população onde o peso médio é 70kg e temos um indivíduo retirado aleatoriamente dessa população que pesa 65kg. Então o erro desse indivíduo é -5kg.

Em contrapartida, quando falamos de resíduos, estamos buscando uma estimativa do erro não observado. Nesse caso, estamos falando, por exemplo, de retirar uma amostra aleatória de uma população e tiramos a média amostral. A diferença entre a média amostral e algum indivíduo retirado dela, isso sim é o resíduo!

Facilitou?

Regressão Linear Simples – Parte 2

Vamos tentar entender a Regressão Linear Simples de forma visual (e já aproveitamos para aprender R!).

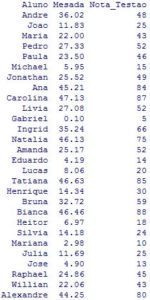

Em nosso exemplo, nós temos dados dos alunos do terceiro colegial da Escola X, suas mesadas em reais e as respectivas notas no Testão contendo todas as matérias.

Acreditamos que o desempenho do aluno melhore com uma mesada a mais, devido ao aumento do bem estar do aluno. Mas será que é verdade? Podemos fazer um modelo para a escola X e verificar isso.

Começamos apresentando os dados e um gráfico de dispersão nas figuras 1 e 2 respectivamente:

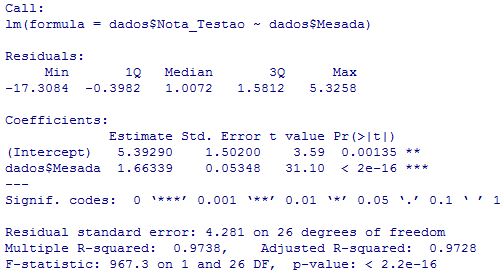

E como vamos saber exatamente quanto que um aumento na mesada impacta a nota dos alunos? Vamos rodar uma regressão no R da variável Mesada (variável independente) em Nota_Testão (nossa variável dependente) e verificar os resultados:

E como vamos saber exatamente quanto que um aumento na mesada impacta a nota dos alunos? Vamos rodar uma regressão no R da variável Mesada (variável independente) em Nota_Testão (nossa variável dependente) e verificar os resultados:

O que nos importa do resultado acima?

O que nos importa do resultado acima?

Com certeza tudo! O R não soltaria tanta coisa para nada.

Mas deixemos “tudo” de lado e hoje vamos apenas focar nos valores em estimate. Esses valores são os chamados BETAS da nossa regressão, e nada mais são do que os valores de a e b da nossa reta, mencionada no post anterior.

Ou seja, o que estamos querendo dizer aqui, é que a nota de um aluno no Testão será 5.39290 somado a 1.66339 multiplicado pela sua mesada. Ou seja, nossa equação da reta, onde y é a nota do Testão e x é a mesada, seria:

y = 5.39290 + 1.66339 * x

Ou seja, para cada 1 real adicionado na mesada, o aluno tira – em média – uma nota 1.66339 maior. Um aluno que ganha 10 reais a mais que seu colega, tira uma nota ~ 16 pontos a mais que seu colega.

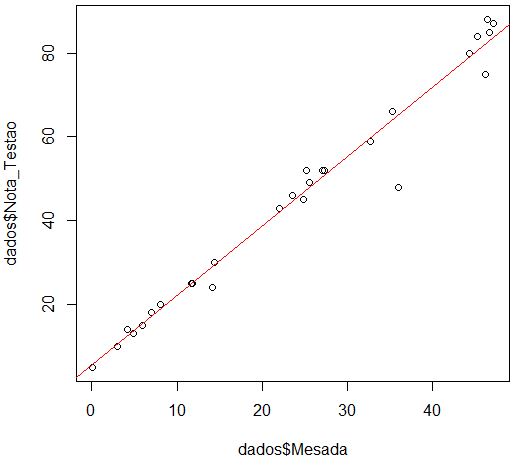

E como é essa aproximação visualmente? É exatamente assim:

Agora, para os iniciantes em R, aí vai 5 linhas de código que gera esses gráficos e essa regressão (para executá-los não colocar os números na frente!):

Agora, para os iniciantes em R, aí vai 5 linhas de código que gera esses gráficos e essa regressão (para executá-los não colocar os números na frente!):

dados <-read.table("C:/Users/Yukio/Desktop/dados_alunos.txt",header=T)

plot(dados$Mesada,dados$Nota_Testao)

regressao <- lm(dados$Mesada ~ dados$Nota_Testao)

abline(lm(dados$Nota_Testao ~ dados$Mesada),col="red")

summary(regressao)

Em breve coloco o que faz cada uma dessas linhas!

Continue seus estudos em: Regressão Linear Simples – Parte 3

Leia também: Resíduos de uma Regressão Linear no R

Problemas com R? Que tal começar em Primeiros passos no R Studio!

Regressão Linear Simples – Parte 1

Nesse primeiro post falaremos, de uma forma mais direta, sem se aprofundar muito, na Regressão Linear Simples.

Digamos que você acredita que a nota do aluno é relacionada com a distância de sua casa até o colégio. Como você verifica se isso é verdade?

Uma regressão linear simples nada mais é do que uma relação linear entre duas variáveis. Ou seja, uma variável, chamada de independente, expressará (de forma linear, linha, reta, etc.) uma outra variável, chamada de independente.

Você se lembra de quando aprendeu a equação de uma reta? Se não lembra, assista a este breve vídeo: Equação da Reta – O Kuadro. Caso não entenda com esse vídeo, há diversos vídeos relacionados no youtube, basta acessar o que for melhor para você.

Pois bem, a Regressão Linear Simples não tem nenhum segredo, ela nada mais é do que uma forma de escrever nosso y em função de x na forma de uma reta. Obviamente, essa equação dificilmente é perfeita, no sentido de que y e x se relacionam linearmente. Portanto, ao invés de escrevermos a famosa equação da reta y = a*x + b, em uma regressão linear simples nossa equação é y = a*x + b + ε, onde o último termo é o nosso erro.

Resumindo tudo que foi dito acima, temos um conjunto de pontos y e x que acreditamos que se relacionem de forma linear, ou seja, que formam uma reta. A regressão linear simples nos dá essa reta.

Continue seus estudos em: Regressão Linear Simples – Parte 2

Leia também: Resíduos de uma Regressão Linear no R

Problemas com R? Que tal começar em Primeiros passos no R Studio!

Regressão Linear vs. Mínimos Quadrados

Já parou para pensar qual a diferença entre Regressão Linear e Método dos Mínimos Quadrados?

Para a maioria das pessoas é a mesma coisa. E realmente são coisas próximas, mas não se confunda, são duas coisas diferentes.

De uma forma bem simples: o famoso método dos Mínimos Quadrados é uma maneira utilizada de se realizar uma Regressão Linear.

Colocado de outra maneira, uma Regressão Linear é uma equação (linear!) que explica a relação entre duas variáveis, uma independente e outra dependente.

Mínimos Quadrados é a minimização das somas, neste caso, dos erros da equação encontrada. Que fique claro que os Mínimos Quadrados podem ser utilizados para outros problemas de otimização!